写在前面CDH系列默认阉割掉了Spark的sparksql工具spark-sql客户端,但是很多公司还是有这个使用的需要spark-sql客户端,因为线上就有这块的需求spark-sql客户端,所以结合。

Spark SQL客户端查询可以通过Sparkshell来操作Spark SQLspark-sql客户端,spark作为SparkSession的变量名,sc作为SparkContext的变量名可以。

可以接收客户端对于 Hive 的请求c 当我们创建 Java 连接 spark SQL 的应用,就是去连接 Hive Server那么 Spark SQL JDBC Server 的。

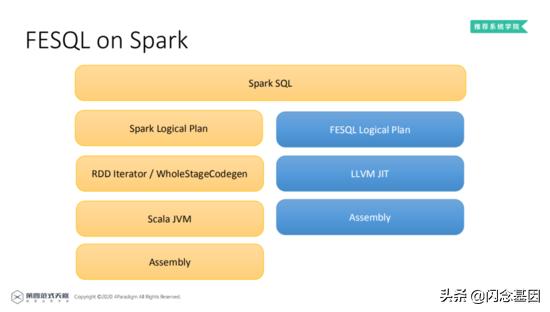

站在通用的角度,对于SparkSql来说,从Sql到Spark的RDD执行需要经历两个大的阶段逻辑计划和物理计划逻辑计划层面会把用户。

进入到sparksql 客户端命令行界面查看当前有哪些数据库, 并创建数据库show databasescreate database sparkhive方式2PySpark。

Spark SQL的概念理解 Spark SQL是spark套件中一个模板,它将数据的计算任务通过SQL的形式转换成了RDD的计算Spark SQL查询方式 DataFrame查询方式 1DataFrame支持两种查询方式一种是DSL风格DataFrameDataset和RDD互操作 1RDDDataFrame 普通方式例如rddmapparapara0。

标签: spark-sql客户端